LASSO与Item Response Theory模型中的隐变量选择

这是Latent Variable Selection for Multidimensional Item Response Theory Models via L1 Regularization的简单介绍。

Item Response Theory简介

在心理学中,有很多用于测量个人特质(trait)与dichotomous-response、polytomous-response item(就是用一些二选或者多选的问题来看被试者在一些具体场景中的反应)的量表和实验,基于这些量表与实验的测量结果,心理学家可以发掘item-trait之间的关系。

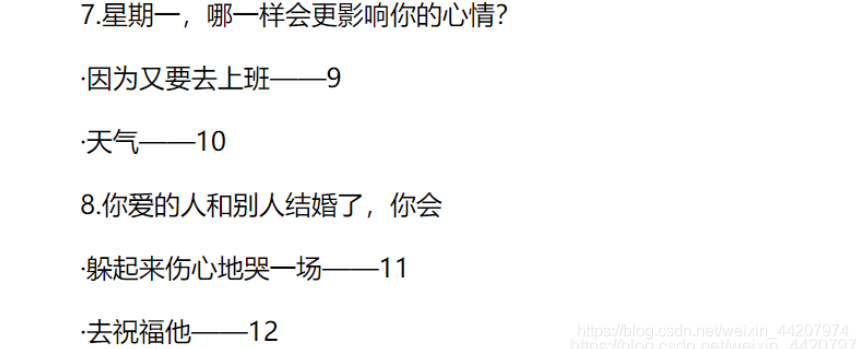

下面是几个二选的例子(如何应对坏男人)

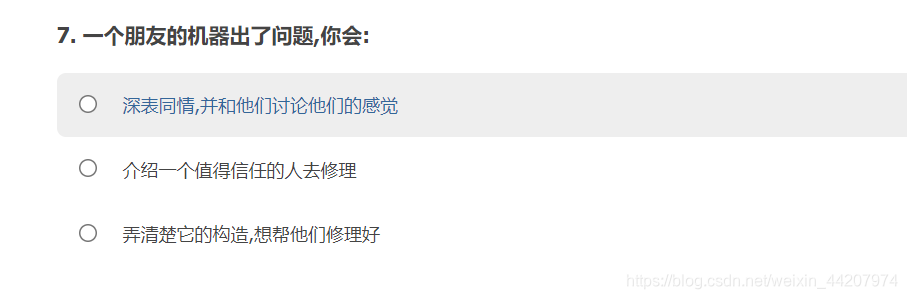

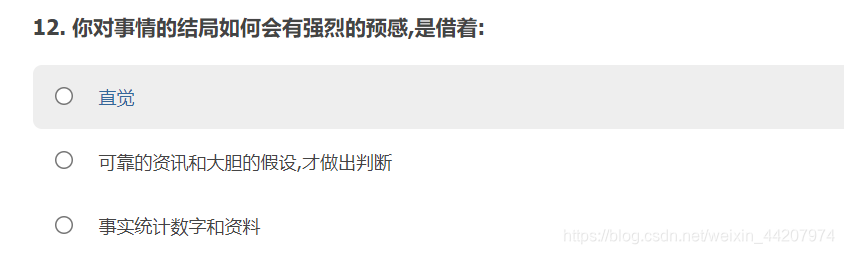

下面是两个多选问题的例子(gender-orientation的测试)

统计模型

Item Response Theory (IRT)就是很常用的描述item-trait relation的统计模型。用 θ = ( θ 1 , ⋯ , θ K ) T \theta=(\theta^1,\cdots,\theta^K)^T θ=(θ1,⋯,θK)T表示被试者的特质向量(这个是不可测量的),每一个分量表示被试者的一种潜在特质;考虑 J J J个二选题组成的量表,用 Y j Y_j Yj表示被试者对第 j j j个问题的回答,假设我们讨论两参数模型

P ( Y j = 1 ∣ θ ) = F ( a j T θ + b j ) P(Y_j=1|\theta)=F(a_j^T\theta+b_j) P(Yj=1∣θ)=F(ajTθ+bj)

其中 a j = ( a j 1 , ⋯ , a j K ) T a_j=(a_{j1},\cdots,a_{jK})^T aj=(aj1,⋯,ajK)T, F ( ⋅ ) F(\cdot) F(⋅)是一个累积分布函数,定义

A = ( a 1 , ⋯ , a J ) , b = ( b 1 , ⋯ , b J ) T A = (a_1,\cdots,a_J),b=(b_1,\cdots,b_J)^T A=(a1,⋯,aJ),b=(b1,⋯,bJ)T

称 a j a_j aj为discrimination parameter vector, b j b_j bj为difficulty parameter。如果 a j k ≠ 0 a_{jk} \ne 0 ajk=0,就可以认为特质 k k k在被试者对第 j j j个问题做出1的回应中起到了一定作用。于是,为了构建特质与被试者在不同情景中的反应之间的关系,我们希望找出在被试者对每一个问题做出回应的过程中起作用的那些特质,这个正是variable selection可以解决的。正式描述的话就是我们希望估计一个0-1矩阵

Λ = ( λ j k ) J × K , λ j k = I a j k ≠ 0 \Lambda=(\lambda_{jk})_{J \times K}, \lambda_{jk}=I_{a_{jk} \ne 0} Λ=(λjk)J×K,λjk=Iajk=0

用来描述item-trait relation。

另外,关于 F F F有两种流行的选择:

Normal Ogive Model

P ( Y j = 1 ∣ θ , a j , b j ) = ∫ − ∞ a j T θ + b j e − u 2 2 2 π d u P(Y_j=1|\theta,a_j,b_j)=\int_{-\infty}^{a_j^T\theta+b_j}\frac{e^{-\frac{u^2}{2}}}{\sqrt{2\pi}}du P(Yj=1∣θ,aj,bj)=∫−∞ajTθ+bj2πe−2u2du

Logistics Model

P ( Y j = 1 ∣ θ , a j , b j ) = exp ( a j T θ + b j ) 1 + exp ( a j T θ + b j ) P(Y_j=1|\theta,a_j,b_j)=\frac{\exp(a_j^T\theta+b_j)}{1+\exp(a_j^T\theta+b_j)} P(Yj=1∣θ,aj,bj)=1+exp(ajTθ+bj)exp(ajTθ+bj)

在原文中,作者也讨论了一种三参数模型:

P ( Y j = 1 ∣ θ , a j , b j , c j ) = c j + ( 1 − c j ) F ( a j T θ + b j ) P(Y_j=1|\theta,a_j,b_j,c_j)=c_j+(1-c_j)F(a_j^T\theta+b_j) P(Yj=1∣θ,aj,bj,cj)=cj+(1−cj)F(ajTθ+bj)

c j c_j cj表示guessing probability。

Latent Traits Selection

两参数模型的LASSO

假设有 N N N个被试者,他们对 J J J个问题的回答用 Y = ( Y i j ) N × J Y=(Y_{ij})_{N \times J} Y=(Yij)N×J表示,他们的特质满足 θ 1 , ⋯ , θ N ∼ i i d N ( 0 , Σ ) \theta_1,\cdots,\theta_N \sim_{iid} N(0,\Sigma) θ1,⋯,θN∼iidN(0,Σ)(概率密度记为 ϕ ( θ ) \phi(\theta) ϕ(θ)),记 Θ = ( θ 1 , ⋯ , θ N ) \Theta=(\theta_1,\cdots,\theta_N) Θ=(θ1,⋯,θN),于是两参数模型的似然函数为(包含complete data Y Y Y与missing data Θ \Theta Θ)

L ( A , b ∣ Y , Θ ) = ∏ i = 1 N ϕ ( θ i ) ∏ j = 1 J [ F ( a j T θ i + b j ) ] y i j [ 1 − F ( a j T θ i + b j ) ] 1 − y i j L(A,b|Y,\Theta)=\prod_{i=1}^N\phi(\theta_i)\prod_{j=1}^J [F(a_j^T \theta_i+b_j)]^{y_{ij}} \left[1-F(a_j^T\theta_i+b_j) \right]^{1-y_{ij}} L(A,b∣Y,Θ)=i=1∏Nϕ(θi)j=1∏J[F(ajTθi+bj)]yij[1−F(ajTθi+bj)]1−yij

complete data的对数似然为

l ( A , b ∣ Y ) = log ∫ Θ ∈ R K × N L ( A , b ∣ Y , Θ ) d Θ l(A,b|Y)=\log \int_{\Theta \in \mathbb{R}^{K \times N}} L(A,b|Y,\Theta)d \Theta l(A,b∣Y)=log∫Θ∈RK×NL(A,b∣Y,Θ)dΘ

用complete data的对数似然扣掉discrimination parameter的LASSO penalty作为score function,最大化score function可以得到参数的LASSO估计:

( A ^ η , b ^ η ) = arg max l ( A , b ∣ Y ) − η ∥ A ∥ 1 (\hat A_{\eta},\hat b_{\eta})=\argmax \ \ l(A,b|Y)-\eta \left\| A\right\|_1 (A^η,b^η)=argmax l(A,b∣Y)−η∥A∥1

其中 η > 0 \eta>0 η>0是regularization parameter,

∥ A ∥ 1 = ∑ j = 1 J ∑ k = 1 K ∣ a j k ∣ \left\|A\right\|_1=\sum_{j=1}^J \sum_{k=1}^K |a_{jk}| ∥A∥1=j=1∑Jk=1∑K∣ajk∣

如果 η = 0 \eta=0 η=0,那么LASSO估计退化为MLE。

BIC for tuning

原文作者采用BIC选择regularization parameter η \eta η,IRT的BIC定义为

B I C ( Λ ∗ ) = − 2 max Λ ( A ) = Λ ∗ , b l ( A , b ∣ Y ) + ∥ A ∥ 0 log N ∥ A ∥ 0 = ∑ j , k I a j k ≠ 0 BIC(\Lambda^*)=-2\max_{\Lambda(A)=\Lambda^*,b}l(A,b|Y)+\left\|A \right\|_0\log N \\ \left\| A\right\|_0=\sum_{j,k}I_{a_{jk} \ne 0} BIC(Λ∗)=−2Λ(A)=Λ∗,bmaxl(A,b∣Y)+∥A∥0logN∥A∥0=j,k∑Iajk=0

在两参数模型的LASSO中,我们可以按下面的步骤做tuning:

- 给定一个 η \eta η的取值,得到两参数模型的LASSO估计 A ^ η , b ^ η \hat A_{\eta},\hat b_{\eta} A^η,b^η

- 根据 A ^ η \hat A_{\eta} A^η写出指标矩阵 Λ η = Λ ( A ^ η ) \Lambda_{\eta}=\Lambda(\hat A_{\eta}) Λη=Λ(A^η)

- 对于 Λ η \Lambda_{\eta} Λη,计算 B I C ( Λ η ) BIC(\Lambda_{\eta}) BIC(Λη)

对于 η \eta η取值的一个范围,计算出对应的 B I C BIC BIC后选出 B I C BIC BIC最小的 η ∗ \eta^* η∗作为regularization parameter。

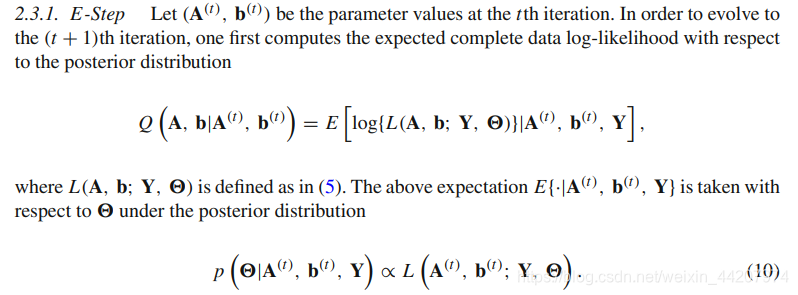

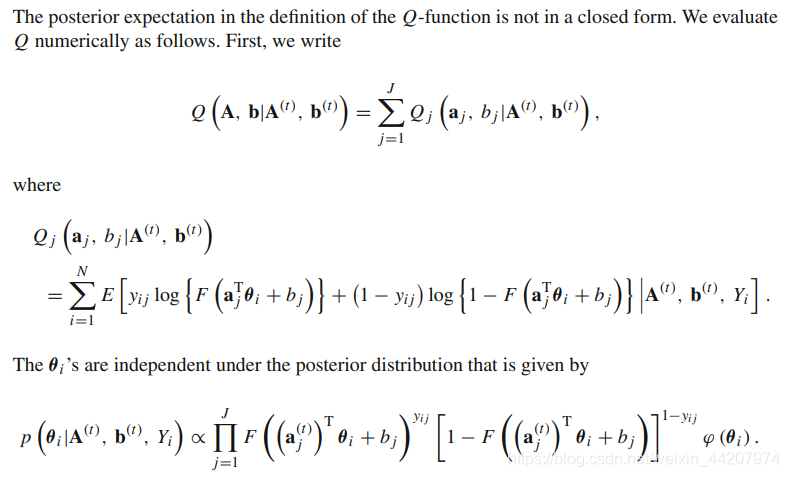

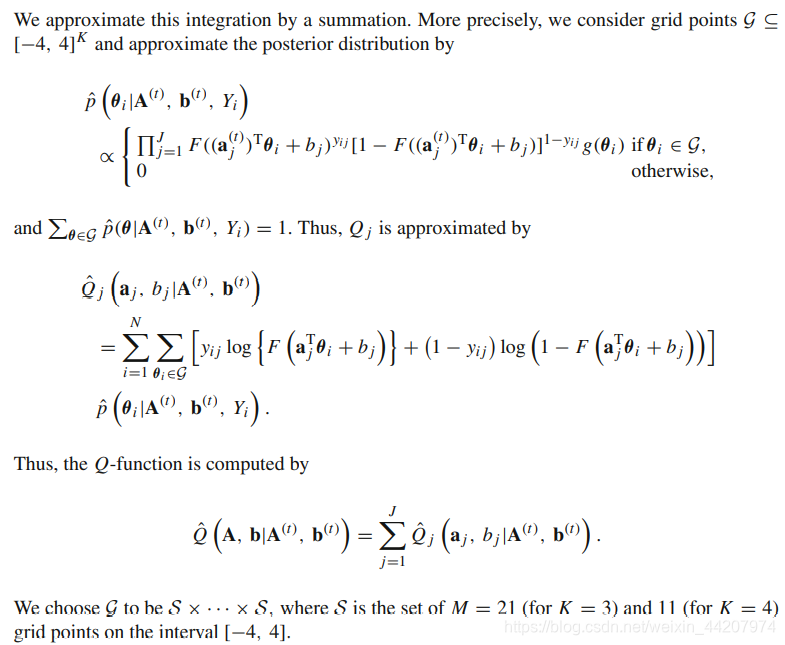

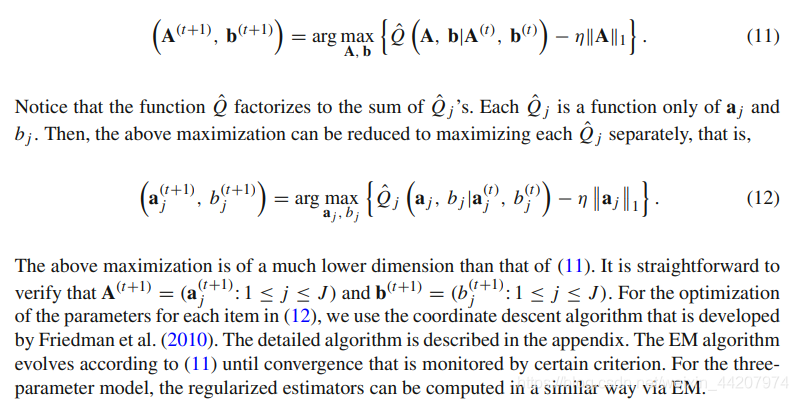

Latent traits selection的EM算法

这部分我暂时不关注,所以贴原文(希望了解更多细节与数值实验的同学可以自行阅读全文)