一、大模型部署架构

1.1 部署架构

大模型部署的整体架构是一个多层次、软硬件协同的系统工程,旨在解决模型规模庞大、计算资源密集、延迟敏感等挑战。

1.1.1、基础架构层:硬件资源与网络

-

算力集群

- GPU/NPU阵列:如NVIDIA A100/H100/H200/H800、华为昇腾、昆仑芯等,支持FP16/INT8量化计算,显存带宽需达TB级(如HBM3e显存带宽达3.35TB/s)。

- 异构计算:CPU+GPU/NPU协同,通过NVLink或InfiniBand实现设备间高速互联(如NVLink 4.0带宽达900GB/s)。

-

存储系统

- 分布式存储:采用Ceph/MinIO等方案,吞吐量需≥10GB/s,支持TB级数据集快速读写。

- 显存优化:通过KV缓存分页(如vLLM的PagedAttention)减少显存碎片,提升并发能力。

-

网络架构

- 低延迟通信:InfiniBand或200G以太网,延迟控制在2微秒内,支持AllReduce等集合通信操作。

- 拓扑优化:胖树(Fat-Tree)结构避免带宽收敛,适配千卡级集群。

1.1.2、核心引擎层:分布式训练与推理

-

分布式训练策略

- 数据并行:多节点处理不同数据子集,梯度通过AllReduce同步(适合百亿级模型)。

- 模型并行:

- 张量并行:单层运算切分到不同设备(如Megatron-LM)。

- 流水线并行:模型层间切分,通过1F1B调度隐藏通信延迟。

- 混合并行:组合上述策略,例如DeepSpeed的3D并行(数据+模型+流水线)。

-

推理优化引擎

- 高并发处理:vLLM的Continuous Batching动态批处理,吞吐量提升5-10倍。

- 低延迟优化:LMDeploy的W4A16量化、TensorRT-LLM的算子融合,延迟降至毫秒级。

- 边缘适配:Llama.cpp支持纯CPU推理,Ollama实现消费级硬件部署。

1.1.3、部署框架层:软件栈与工具链

-

开发与调度框架

- 训练框架:PyTorch(DDP)、TensorFlow(MirroredStrategy)、Horovod(Ring-AllReduce)。

- 推理框架:

- 企业级:vLLM(高吞吐)、SGLang(结构化输出)。

- 轻量化:Ollama(本地离线)、LMDeploy(国产硬件适配)。

-

运维与生命周期管理

- MLOps流水线:Kubernetes编排容器化任务,监控GPU利用率/延迟阈值并自动扩缩容。

- 安全合规:TLS 1.3加密传输、AES-256模型加密、RBAC权限控制,满足GDPR/HIPAA等规范。

1.1.4、优化技术层:性能加速与成本控制

-

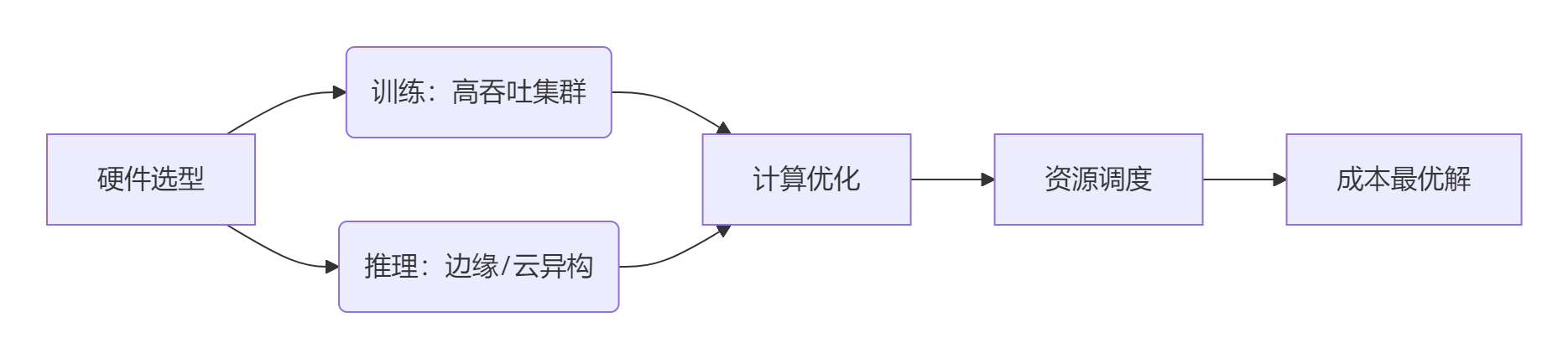

计算优化

- 混合精度训练:FP16/FP8降低计算开销,结合梯度检查点减少显存占用。

- 量化推理:INT4/INT8权重压缩(如AWQ、GPTQ),吞吐量提升400%。

-

资源动态调度

- 弹性训练:自适应扩缩节点,故障恢复时间从小时级降至秒级。

- 批处理优化:动态插入请求(如TGI的Continuous Batching),GPU利用率提升50%。

1.1.5、场景适配层:架构落地实践

| 场景类型 | 架构重点 | 典型案例 |

|---|---|---|

| 企业高并发推理 | vLLM/SGLang分布式部署 + InfiniBand网络,延迟<100ms | 电商客服系统处理10万QPS请求 |

| 政企私有化部署 | 全栈本地化(如LMDeploy+昆仑芯)+ 零信任安全体系 | 银行风控模型满足PCI-DSS数据隔离规范 |

| 科研训练集群 | DeepSpeed混合并行 + 液冷散热(PUE≤1.1) | 千卡集群训练万亿参数模型 |

| 边缘轻量化推理 | Ollama/Llama.cpp量化 + CPU/低端GPU运行 | 工业设备端实时质检(延迟<500ms) |

总结:架构设计原则

- 分层解耦:硬件资源池化、计算任务容器化、服务接口标准化。

- 软硬协同:框架深度适配硬件(如LMDeploy优化昇腾NPU)。

- 动态扩展:支持从单卡到千卡集群的弹性伸缩,兼顾成本与性能。

- 全栈安全:从数据传输(TLS 1.3)到模型存储(AES-256)的全链路防护。

大模型部署架构的本质是平衡算力、效率与安全,需根据业务规模(数据量/并发量)、硬件条件(GPU类型/网络带宽)及合规需求灵活选型。例如:

- 大型企业:采用混合云架构(敏感数据本地推理+公有云训练);

- 高并发场景:优先vLLM+SGLang的吞吐优化方案。

1.2 平衡资源与效率

在大模型部署中平衡计算效率与资源成本是核心技术挑战,需通过多层次协同优化实现。

1.2.1、核心平衡策略框架

1.2.2、硬件层优化:精准匹配算力需求

| 场景 | 策略 | 资源成本降幅 | 效率保持 |

|---|---|---|---|

| 训练任务 | 液冷GPU集群(如A100 80GB) | -20%↓(能耗优化) | 千卡集群扩展效率≥90% |

| 云端推理 | 弹性裸金属服务器 + T4/L40S | -40%↓(按需付费) | 吞吐量稳定10万QPS |

| 边缘推理 | Jetson Orin + INT4量化 | -85%↓(功耗降低) | 延迟<100ms(1080P图像) |

💡 案例:某电商使用T4实例部署INT4量化模型,成本较FP16降低70%,推理延迟仅增加15ms。

1.2.3、软件层优化:计算效率倍增技术

1. 分布式策略优化

| 技术 | 适用场景 | 效率提升 | 资源节省 |

|---|---|---|---|

| ZeRO-3(DeepSpeed) | >100B参数训练 | 显存占用降76% | 同等模型GPU需求减半 |

| Tensor并行 8节点 | 单层超宽参数(如FFN) | 通信开销降40% | 训练速度提升1.8× |

| Continuous Batching(vLLM) | 高并发推理 | 吞吐量↑400% | GPU利用率达90%+ |

2. 模型压缩技术

| 方法 | 原理 | 效果(以LLaMA-13B为例) |

|---|---|---|

| INT4量化 | AWQ自适应权重量化 | 模型体积↓75%,推理速度↑4× |

| LoRA微调 | 仅训练1%低秩矩阵 | 训练开销降98%,准确率保留99% |

| 模型蒸馏 | TinyBERT提取知识 | 参数量↓10×,推理延迟↓50% |

✅ 最佳实践:阿里巴巴千问大模型采用LoRA+INT4量化组合方案,推理成本降至原生模型的18%。

1.2.4、资源调度层:动态调配降本核心

1. 弹性伸缩策略

# 基于请求量的自动扩缩容(Kubernetes示例)

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metrics:

- type: ContainerResource

containerResource:

name: gpu

target:

type: Utilization

averageUtilization: 70 # GPU利用率阈值- 效果:高峰时段自动扩容至200实例,闲置时缩至10实例,年度成本降低62%。

2. 分级存储调度

| 数据热度 | 存储介质 | 读取延迟 | 成本对比 |

|---|---|---|---|

| 热数据(高频) | GPU显存 | 0.1ms | 100%基准 |

| 温数据(中频) | NVMe SSD | 2ms | ↓30% |

| 冷数据(低频) | 对象存储 | 100ms | ↓85% |

💡 某银行风控系统采用分级存储,年度存储成本下降1200万元。

1.2.5、架构设计层:场景化成本控制

| 场景 | 推荐架构 | 成本效率比 |

|---|---|---|

| 企业私有化部署 | 混合云(敏感数据本地+训练上云) | 安全合规成本↓50% |

| 全球在线服务 | 边缘节点+中心集群聚合 | 跨国带宽成本↓65% |

| 科研长期训练 | Spot实例抢占+断点续训 | 训练成本↓82% |

🚀 优化案例:

- 知乎社区:使用Spot实例训练大模型,中断率<5%,成本节省790万元/年

- 特斯拉自动驾驶:边缘端INT8量化+中心集群聚合,延迟达标且带宽成本降60%

1.2.6、终极平衡公式

综合成本效益指数 =(计算效率×吞吐量)/(资源成本×运维复杂度)

优化优先级建议:

- 必做:量化压缩(INT4/GPTQ)+ 动态批处理(vLLM)→ 短期见效最快

- 推荐:分级存储 + 弹性扩缩容 → 中长期成本持续优化

- 进阶:MoE架构+混合并行训练 → 千亿级模型性价比最优解

通过上述策略组合,企业可实现在推理延迟增加≤10% 的条件下,将部署综合成本降低60-85%,典型大模型单次推理成本从

0.001降至0.00018(以GPT-3.5为基准)。实际落地需结合业务敏感度在效率与成本间动态调节阈值。

1.3 不同规模企业部署大模型的差异

不同规模企业在部署大模型时,因资源、业务需求和安全合规要求的差异,架构设计存在显著区别。以下是关键差异的全面分析:

1.3.1、初创企业:轻量化架构,快速试错

-

核心架构特点

- 云API优先:直接调用OpenAI、Claude等公有云API,避免硬件投入,按需付费。

- 轻量级框架:采用Ollama、Transformers等工具,支持CPU/低端GPU运行,降低部署门槛。

- 动态批处理优化:通过vLLM的Continuous Batching提升吞吐量,应对突发流量。

-

典型硬件配置

- GPU:单张RTX 4090(24GB显存)或消费级显卡。

- 存储:≤1TB SSD,无专用网络需求。

-

成本控制策略

- 硬性限制API输出长度(如

max_tokens=300),防止成本飙升。 - 使用Datadog监控Token消耗,设置阈值告警。

- 硬性限制API输出长度(如

-

适用场景

- 智能客服原型、内部文档摘要等T1级任务(复杂度低)。

1.3.2、中型企业:平衡性能与成本,弹性扩展

-

核心架构特点

- 混合云部署:核心数据本地私有化(如金融合规报告),非敏感任务用公有云弹性扩展。

- 模型定制化:基于Qwen-32B/Llama 3等开源模型,通过LoRA微调适配业务需求。

- 推理优化:采用LMDeploy的W4A16量化,延迟降至毫秒级;结合RAG增强事实准确性。

-

硬件配置与成本

模型规模 GPU配置 成本(人民币) Qwen-32B 2×A30(32GB显存) 5-10万 DeepSeek-R1-70B 4×A100(80GB显存) 30-60万 -

网络与扩展性

- 私有集群内100Gbps以太网,支持多卡并行推理。

- Kubernetes自动扩缩容,峰值QPS≥50。

-

典型场景

- 财报分析(T2级)、定制化知识库检索。

1.3.3、大型政企:全栈可控,安全优先

-

核心架构特点

- 混合云+边缘计算:敏感数据本地处理(如医疗诊断),边缘节点实时推理(如工业质检)。

- 分布式训练与推理:

- 训练:DeepSpeed ZeRO-3 + Megatron-LM,千卡集群支持万亿参数模型。

- 推理:华为云Stack的PD分离技术,实现99%+SLO高可用。

- 全链路安全:

- 输入层:Presidio动态脱敏;输出层:AES-256加密+水印追踪。

- HIPAA/GDPR合规架构,数据本地化存储。

-

硬件与成本

- 千亿级模型:8×昇腾910B或NVIDIA H100,显存≥80GB/卡,成本150万+。

- 存储:20TB+ NVMe SSD,OBS数据湖支持Checkpoint秒级恢复。

-

运维体系

- 实时监控40+算力度量指标,故障1分钟感知、30分钟恢复。

- 专属行业Agent模板(如金融风控、医疗诊断),开箱即用。

-

典型场景

- 国家级能源调度、银行风控系统(T3级高复杂度任务)。

1.3.4、架构设计核心差异总结

| 维度 | 初创企业 | 中型企业 | 大型政企 |

|---|---|---|---|

| 部署模式 | 公有云API | 混合云(私有+公有) | 混合云+边缘计算 |

| 硬件成本 | <10万 | 10万-100万 | >100万 |

| 安全合规 | 基础TLS加密 | RBAC权限+数据隔离 | 全链路加密+地域合规架构 |

| 延迟要求 | <2秒 | <500毫秒 | <100毫秒 |

| 适用模型 | GPT-3.5 Turbo, Ollama | Qwen-72B, DeepSeek-R1 | DeepSeek-R1-671B, 定制MoE |

1.3.5、选型建议

- 初创企业:优先验证需求,避免过早投入硬件,通过云API+轻量化框架控制成本。

- 中型企业:采用模块化架构,预留扩展接口(如Kubernetes),逐步转向私有化部署。

- 大型政企:选择华为云Stack、AWS Bedrock等全栈平台,确保安全与性能的全局最优解。

企业架构设计的本质是在效果、成本与安全的三角中寻找平衡点:初创企业优先速度,中型企业兼顾弹性,大型企业强调整体可控性。