简介:该项目是一个开源的源代码压缩包,专注于将Intel Realsense D435深度相机与Nuitrack手势识别技术在Unity游戏引擎中进行整合。Realsense D435相机是一款提供高精度3D点云数据的RGB-D相机,非常适合实时环境感知和对象识别。Nuitrack SDK允许开发者实现实时手部跟踪和手势识别,使得Unity场景能够支持基于手势的交互功能。项目包含C++或C#编程语言文件和Unity工程文件,提供了示例场景、配置文件和文档,以便开发者理解和使用该SDK。开发者可以通过此项目实现手部关节实时跟踪、识别不同手势,并将结果应用于Unity交互式应用开发。

1. Realsense D435深度相机介绍

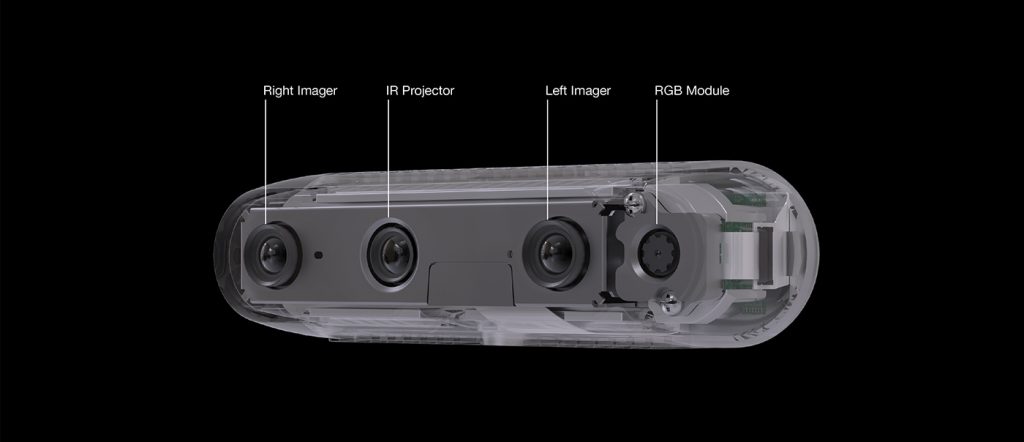

Realsense D435深度相机是Intel开发的一款面向开发者和商业用户的先进深度感知相机。它支持RGB图像和深度数据的实时捕捉,并且体积轻巧,易于集成到各种应用场景中。相机通过USB 3.1接口连接,能够达到每秒30帧的高分辨率深度图像捕获,分辨率高达1280x720。

深度感知技术的应用

深度相机的出现开启了新的交互方式,比如手势识别和三维空间扫描。Realsense D435特别适用于需要精确空间感知的场景,比如增强现实(AR)、虚拟现实(VR)、机器人导航以及人脸和身体动作追踪。

精准的深度感应

Realsense D435搭载了英特尔的RealSense Vision Processor D4,集成了深度流和RGB流的硬件加速功能,可以实现先进的视觉处理算法,如物体检测、手势识别等。相机也使用了结构光技术,通过红外投射和分析图案的变形来精确测量深度信息。

在接下来的章节中,我们会深入探讨Realsense D435如何与其他技术如Nuitrack手势识别技术协作,共同提升用户体验,并讨论其在多种实际应用中的潜力。

2. Nuitrack手势识别技术概述

Nuitrack 是一种先进的手势识别技术,它通过深度相机来实现无需触控的交互体验。该技术不仅能够识别手部动作,还能跟踪全身运动,使得开发者能够在各种应用程序中构建直观而自然的交互方式。

2.1 Nuitrack技术的原理与特点

2.1.1 体感技术与传感器融合

Nuitrack 是基于深度学习和图像处理技术的体感解决方案,通过使用深度相机捕获人体及物体的三维空间信息,实现对场景的深度感知。深度相机通常包含红外发射器和红外摄像头,能够测量场景中物体表面的距离,生成深度图。

要整合Nuitrack到你的项目中,首先需要理解传感器融合的概念,即结合来自不同传感器的数据来提高系统的整体性能和准确性。Nuitrack 能够结合多个传感器的数据,比如加速计、陀螺仪等,实现更精准的运动追踪和手势识别。

2.1.2 手势识别的核心算法解析

手势识别算法是Nuitrack技术的核心。该算法首先对深度图像进行预处理,包括滤波、去噪等步骤。接下来,算法会进行人体姿态估计,通过骨架跟踪技术,它能够识别出人体各个关节的位置。针对手部区域,算法进一步分析手势形状,从而实现手势识别。

下面是一个简化的骨架跟踪算法伪代码示例:

def track_skeleton(depth_frame):

"""

伪代码:骨架跟踪函数

:param depth_frame: 深度相机获取的帧数据

:return: skeleton: 跟踪得到的骨架数据

"""

# 深度帧预处理

filtered_frame = preprocess_depth_frame(depth_frame)

# 人体检测

human_region = detect_human_region(filtered_frame)

# 骨架估计

skeleton = estimate_skeleton(human_region)

# 手部区域的手势识别

if detect_hand_region(skeleton):

hand_gesture = recognize_gesture(skeleton)

skeleton.hand_gesture = hand_gesture

return skeleton

在实际应用中,Nuitrack SDK会提供更加完善的实现,并提供应用程序接口(API)供开发者调用。

2.2 Nuitrack在多场景中的应用实例

2.2.1 虚拟现实与增强现实中的应用

虚拟现实(VR)和增强现实(AR)是Nuitrack技术的一大应用场景。在VR中,通过手势识别可以模拟真实世界的手部操作,提升用户的沉浸感。而在AR中,手势识别可以用来进行与虚拟物体的交互,使得虚拟信息能够与现实世界无缝结合。

例如,在VR游戏中,玩家可以通过自然的手势来拾取虚拟物品或与虚拟角色进行交互。以下是使用Nuitrack实现VR手势控制的一个简化示例:

def vr_gesture_control():

"""

伪代码:VR手势控制函数

"""

while True:

depth_frame = get_depth_frame() # 获取深度帧

skeleton = track_skeleton(depth_frame) # 跟踪骨架

if skeleton.hand_gesture == "GRAB":

# 模拟抓取动作

grab_object()

elif skeleton.hand_gesture == "SWIPE":

# 模拟滑动动作

swipe_screen()

# ... 其他手势对应的控制逻辑

2.2.2 教育、康复和游戏中的应用

在教育领域,手势识别技术可以用来设计互动式学习软件,增强学习的趣味性和参与感。康复领域中,手势识别可用于辅助康复训练,通过游戏化的形式鼓励患者进行物理治疗。而在游戏开发中,Nuitrack技术提供了一种新的游戏控制方式,使得游戏体验更加丰富和有趣。

这里是一个教育应用中的简化代码示例,展示了如何使用Nuitrack进行教学互动:

def interactive_education_app():

"""

伪代码:互动式教育应用函数

"""

while True:

depth_frame = get_depth_frame() # 获取深度帧

skeleton = track_skeleton(depth_frame) # 跟踪骨架

if skeleton.hand_gesture == "TAP":

# 用户完成特定手势动作,给予反馈

feedback_user("Correct gesture! Well done!")

# ... 其他互动逻辑

通过Nuitrack技术的集成与应用,开发者能够创建出更加丰富和创新的用户体验,这将在诸多领域中引发变革。

3. Unity游戏引擎集成

在游戏开发领域,Unity游戏引擎一直被认为是方便易用且功能强大的工具,它支持多平台发布,拥有庞大的开发社区和丰富的插件生态系统。而当将Unity与Nuitrack技术结合时,开发者可以创建出全新的手势控制游戏和应用。接下来将深入探讨如何在Unity中集成Nuitrack技术,以及如何处理手势识别数据来实现交互式游戏逻辑。

3.1 Unity集成Nuitrack技术的准备工作

3.1.1 环境搭建与软件安装

在开始集成Nuitrack之前,首先需要确保你的开发环境已经搭建好。你需要有一台配置较高的电脑,安装有最新版的Unity编辑器,并且系统需要满足Nuitrack SDK的最低硬件要求。

准备工作包括以下几个步骤:

-

安装最新版的Unity编辑器 :访问Unity官网下载并安装最新版的Unity Hub和编辑器。在安装时选择适用于你开发需求的模块。

-

创建Unity项目 :使用Unity Hub创建一个全新的Unity项目,可以选择3D模板开始。

-

下载Nuitrack SDK :前往Nuitrack官网,注册账号并下载适用于Unity的SDK。

-

安装Nuitrack SDK :解压下载的Nuitrack SDK文件,并按照安装指南进行安装。

3.1.2 Nuitrack SDK与Unity插件的配置

在Unity项目中集成Nuitrack需要一些额外的配置,以确保SDK能够正确与Unity引擎交互。

-

导入Nuitrack Unity插件 :将Nuitrack提供的Unity插件包导入到你的Unity项目中。

-

配置Nuitrack License :在项目中添加你的Nuitrack License Key,以解锁Nuitrack的全部功能。

-

设置Nuitrack场景和脚本 :在Unity的场景中添加Nuitrack场景和相关的脚本组件。这会初始化Nuitrack SDK并开始捕捉用户的动作。

-

调整Nuitrack的用户参数 :根据你的应用需求,可以调整Nuitrack的用户参数,如跟踪模式、跟踪质量等。

完成以上步骤后,你的Unity环境应该已经准备就绪,可以开始手势识别的开发工作了。

3.2 手势识别与Unity游戏开发

手势识别与Unity游戏开发的结合可以开启全新的互动方式。开发者可以捕捉玩家的手势动作,将这些动作转化为游戏内的互动元素,如触发事件、操纵游戏对象等。

3.2.1 手势识别数据在Unity中的处理

Nuitrack在Unity中提供的手势识别数据十分丰富,包括手的位置、手指的弯曲程度等。处理这些数据需要注意以下几点:

-

获取手势数据 :通过Nuitrack提供的API调用,获取玩家的手势数据。

-

数据映射和转换 :将获取的手势数据映射到Unity的3D空间中,确保数据的准确性和实时性。

-

用户界面交互 :根据手势数据来更新UI元素,例如,当玩家做出特定手势时,UI上的按钮可以被按下。

3.2.2 实现交互式游戏逻辑的示例

实现一个简单的交互式游戏逻辑示例,可以加深理解手势识别在游戏开发中的应用。

using UnityEngine;

using NuitrackSDK;

public class HandGestureExample : MonoBehaviour

{

void Update()

{

if (NuitrackManager.UserCount == 0) return; // 确保至少有一个用户被追踪

User current = NuitrackManager.Users[0]; // 获取当前用户的数据

if (!current.IsTracked) return; // 如果用户不被追踪则返回

// 处理手部跟踪数据

if (current.Hands.TryGetValue(SkeletonType.Right, out HandData handData))

{

// 检测并处理特定的手势

if (handData.IsFingerBent(FingerType.Thumb) && handData.IsFingerBent(FingerType.Index))

{

// 如果大拇指和食指捏合,执行动作,例如拾取物品

Debug.Log("Picking up an object!");

}

}

}

}

在上述代码示例中,通过Nuitrack的 User 和 HandData 类,我们可以获取到用户当前手部的信息,并根据手指弯曲的情况判断是否做出“捏合”手势。一旦检测到捏合手势,程序会在控制台输出信息。

这一节详细介绍了Unity集成Nuitrack的准备工作以及如何处理手势识别数据,下一节将探讨Realsense D435的应用领域及其带来的技术优势。

4. RGB-D相机应用与优势

4.1 RGB-D相机技术概述

RGB-D相机通过结合传统的RGB摄像头和深度摄像头,能够捕捉到场景的彩色图像和对应的深度信息,提供更加丰富和精确的三维数据。通过分析这些数据,开发者能够实现复杂的场景理解和物体识别功能。

4.1.1 RGB-D技术的工作原理

RGB-D技术涉及至少两种不同类型的传感器:RGB传感器负责捕捉场景的颜色信息,而深度传感器则利用红外激光、结构光或其他技术来计算场景中对象的距离。这些数据结合生成三维图像,为计算机视觉和增强现实应用提供了关键的深度信息。

4.1.2 RGB-D与传统RGB相机的对比

与传统的RGB相机相比,RGB-D相机能够提供更丰富的数据,包括像素的精确深度信息。这种能力使得RGB-D相机在需要三维空间理解的应用场景中,例如机器人导航、空间映射和手势识别等方面,具有明显的优势。

4.2 Realsense D435的应用领域

Realsense D435作为Intel开发的RGB-D相机,具有便携、易用和高效的特点,被广泛应用于众多领域,例如工业自动化、人机交互等。

4.2.1 工业自动化与质量检测

在工业生产线上,Realsense D435可以用于物体检测、尺寸测量和质量控制。例如,通过精确的深度信息,可以检测出产品是否有缺陷或变形,并及时调整生产线,提升生产效率和质量。

4.2.2 人机交互与空间映射

Realsense D435在人机交互和空间映射方面同样表现出色。它能够追踪用户的动作并实时更新三维空间模型,从而创建一个对人手动作反应灵敏的交互界面。此外,它还能构建精确的室内环境地图,为机器人和自动驾驶车辆提供导航数据。

表格:RGB-D相机与传统RGB相机对比

| 特性 | RGB-D相机 | 传统RGB相机 | |------|-----------|--------------| | 图像类型 | 彩色图像与深度图像 | 彩色图像 | | 数据量 | 大量深度信息 | 仅彩色信息 | | 应用领域 | AR/VR、3D建模、机器人导航 | 照相、视频录制 | | 精确度 | 高 | 低 | | 成本 | 相对较高 | 较低 |

RGB-D技术的发展对计算机视觉和交互式应用的进步有着重要影响。Realsense D435作为此技术的代表之一,在多个领域展示了其应用潜力,推动了相关技术的进一步发展和创新。

5. 手部跟踪与手势识别功能

5.1 手部跟踪技术详解

5.1.1 手部跟踪的技术难点与解决方案

手部跟踪是实现手势识别功能的核心环节,它的技术难点主要集中在以下几个方面:

-

遮挡处理: 在实际应用中,手部常会遮挡自身或其它物体,这对于跟踪算法来说是一大挑战。解决这一问题需要算法能够智能地识别被遮挡的部分,并通过上下文信息和历史数据进行合理推断。

-

光照变化适应: 光线的变化也会影响图像质量,进而影响跟踪准确性。为此,需要算法对光照变化有一定的适应能力,这可以通过环境光补偿、色彩校正等技术手段实现。

-

复杂背景的处理: 复杂的背景环境会干扰手部特征提取,导致误识别。因此,需要高级的图像处理技术来分离前景与背景,例如深度学习方法。

以下是克服这些难点的一些解决方案:

-

使用深度学习模型进行特征提取: 现代的手部跟踪系统经常采用深度学习方法,如卷积神经网络(CNN),来学习从图像中提取有效特征。这种模型可以学习到如何识别不同形状、大小和肤色的手,以及如何处理遮挡问题。

-

多传感器数据融合: 结合RGB-D相机的多传感器数据,可以提高跟踪的准确性。深度信息对于分离前景和背景尤其有用,因为深度数据提供了额外的几何信息。

-

实时反馈与调整: 系统可以实时监控手部跟踪的准确性,并根据反馈进行调整。如果发现跟踪误差,系统可以重新校准或者采用更加复杂的算法进行修正。

5.1.2 精准跟踪与实时响应的实现

精准的手部跟踪技术需要精确的时序和空间定位能力,从而在视频流中实时地识别和追踪手部动作。以下是实现精准跟踪与实时响应的关键步骤:

-

数据预处理: 处理原始输入数据,例如使用高斯模糊来平滑图像,或者应用色彩空间转换来增强手部的轮廓。

-

特征点检测与匹配: 利用关键点检测算法(如OpenPose)识别手部关键点,并在连续帧之间进行匹配,以此来追踪手部的位置和运动。

-

运动预测: 为了实现实时响应,系统会利用历史数据来预测未来的手部位置和运动。可以使用卡尔曼滤波器或粒子滤波器等算法来预测手部的运动轨迹。

-

实时反馈调整: 系统需要具备快速反馈机制,及时调整跟踪算法的参数以适应环境变化或用户行为。

接下来的代码块演示了一个简单的手部关键点检测的Python代码示例,展示了如何使用OpenPose库进行手部关键点的识别。

# 需要先安装 OpenPose Python API 或者使用 Docker 包装器

from openpose import pyopenpose as op

params = {

"model_folder": "models/",

"hand": True, # 启用手部识别

}

opWrapper = op.WrapperPython()

opWrapper.configure(params)

opWrapper.start()

datum = op.Datum()

imageToProcess = "path_to_your_image.jpg" # 替换为你的图片路径

datum.cvInputData = cv2.imread(imageToProcess)

opWrapper.emplaceAndPop([datum])

print("Hand keypoints: \n" + str(datum.handKeypoints))

# 可视化手部关键点

imageToDraw = datum.cvOutputData

# 这里简化处理,只显示图像

cv2.imshow("Hand Keypoints", imageToDraw)

cv2.waitKey(0)

该代码通过OpenPose库成功检测了手部关键点。输出结果会显示每个检测到的关键点的坐标。在实际应用中,可以对这些点进行进一步的处理,例如,通过运动预测算法来预测下一时序的关键点位置。

5.2 手势识别的应用潜力

5.2.1 手势控制界面的可能性

手势控制技术为用户与界面交互提供了一种全新的方式,从而避免了直接接触物理设备。以下是手势控制界面在不同场景中的应用潜力:

-

免触摸操作: 在餐饮、医疗和制造等行业中,工作人员的手部可能沾有污物,使用手势控制技术可以避免弄脏触控界面。

-

无菌环境: 在医院或实验室中,通过手势控制技术可以减少交叉感染的风险,因为用户不需要直接接触设备。

-

增强现实和虚拟现实: 手势识别技术可以将自然的手势动作转化为控制指令,使用户在AR和VR体验中获得更自然的操作体验。

5.2.2 多手势复杂交互的处理

为了处理复杂的多手势交互,需要采取以下措施:

-

手势数据预处理: 在数据送往模型之前,需要对数据进行平滑和滤波处理,以减少不必要的噪声和异常值。

-

手势分类模型的构建: 需要一个强大的机器学习模型,能够识别各种手势并将其分类。可以使用深度学习方法,如卷积神经网络(CNN)和长短期记忆网络(LSTM),来构建这样的模型。

-

上下文和历史信息的利用: 上下文信息对于理解复杂手势至关重要。系统应当能够利用先前的手势和场景上下文来预测接下来可能出现的手势。

-

交互设计: 在多手势交互系统设计中,要考虑到用户的手势记忆和习惯,设计直观易懂的手势指令集。

5.2.3 多手势复杂交互的代码实现

import numpy as np

from sklearn.svm import SVC

from sklearn.metrics import classification_report

# 假设我们有一个手势数据集,包含不同手势的特征向量

X = np.array([hand_features_for_gesture1, hand_features_for_gesture2, ...])

y = np.array([gesture_label1, gesture_label2, ...])

# 使用支持向量机(SVM)作为分类器

classifier = SVC(kernel='linear')

classifier.fit(X, y)

# 评估分类器的性能

predictions = classifier.predict(X)

print(classification_report(y, predictions))

在这个代码示例中,我们使用了scikit-learn库中的SVC来进行手势的分类。 X 是一个特征向量的数组,每个特征向量代表了从手部跟踪系统中提取的手势数据。 y 包含了与这些特征向量相对应的手势标签。通过拟合SVC模型并进行预测,我们可以评估手势分类模型的准确性和性能。

手势识别技术的潜力不仅仅在于手势本身,还在于如何将这些手势融入到复杂的交互过程中。当手势识别系统与高度复杂的交互设计相结合时,可能创造前所未有的用户体验。这对于交互设计师和软件开发人员来说,既是挑战也是机遇,他们必须不断试验和创新,以实现最佳的用户体验。

6. 交互式应用开发能力

开发交互式应用涉及许多层面,包括用户界面设计、用户体验优化、后端逻辑处理、以及数据安全等多个方面。在本章节中,我们将探讨开发者在交互式应用开发过程中可能面临的挑战与机遇,并详细讨论如何使用各种工具和资源来提高开发效率和应用质量。

6.1 开发者面临的挑战与机遇

6.1.1 交互式应用的用户体验优化

用户体验(UX)是交互式应用成功的关键。优化UX通常从了解用户需求开始,包括用户的行为习惯、使用场景以及期望体验。在设计交互式应用时,开发者需要考虑到易用性、响应速度、界面直观性等因素。

在实践中,开发者可以通过A/B测试来比较不同的用户界面设计方案,收集反馈数据来不断迭代改进。此外,利用热图工具来观察用户与应用的交互,了解用户在哪些区域停留更长时间,哪些操作更频繁。

6.1.2 创新应用开发的案例分析

创新始终是推动行业发展的驱动力。在交互式应用开发领域,开发者可以从各种创新案例中汲取灵感。例如,利用手势识别技术开发的虚拟现实应用,它通过动作捕捉来实现虚拟世界中的交互,为用户带来沉浸式体验。

这些案例通常拥有以下特点:

- 高度集成硬件与软件解决方案

- 利用先进技术实现无接触式交互

- 融合多领域知识,如心理学、计算机视觉等

6.2 开发者调试工具与资源的使用

6.2.1 工具与资源的分类与选择

开发过程中,选择正确的工具和资源对于提高效率和应用质量至关重要。调试工具可大致分类为日志记录工具、性能分析工具、网络抓包工具和模拟器等。

例如:

- 日志记录工具 :如Logcat,用于记录Android应用的运行日志,帮助定位程序问题。

- 性能分析工具 :如VisualVM,用于分析Java应用的性能瓶颈。

- 网络抓包工具 :如Wireshark,用于分析网络层面上的数据传输问题。

- 模拟器 :如Android Studio自带的AVD,用于在不同设备配置上测试应用。

6.2.2 调试流程与优化策略

调试流程应该遵循一定的步骤以确保效率。首先,开发者需要确定问题的范围,然后收集日志和相关数据。接下来,利用调试工具对数据进行分析,定位问题所在。最后,采取相应的优化措施,并对应用进行回归测试,确保问题被彻底解决。

举一个优化策略的例子:

- 在Unity中开发的手势识别应用出现延迟现象。

- 使用Unity Profiler工具来记录帧率、内存使用情况等性能指标。

- 发现内存分配不均衡导致的性能瓶颈。

- 对代码进行优化,比如减少不必要的内存分配,优化算法效率。

- 重新测试应用,并使用性能分析工具确认性能提升。

交互式应用的开发是一个持续进化的过程。随着技术的发展和用户需求的变化,开发者需要不断学习新的工具和技术,以保持竞争力。通过细致的用户体验设计和有效的调试流程,可以开发出更加完善和吸引人的交互式应用。

简介:该项目是一个开源的源代码压缩包,专注于将Intel Realsense D435深度相机与Nuitrack手势识别技术在Unity游戏引擎中进行整合。Realsense D435相机是一款提供高精度3D点云数据的RGB-D相机,非常适合实时环境感知和对象识别。Nuitrack SDK允许开发者实现实时手部跟踪和手势识别,使得Unity场景能够支持基于手势的交互功能。项目包含C++或C#编程语言文件和Unity工程文件,提供了示例场景、配置文件和文档,以便开发者理解和使用该SDK。开发者可以通过此项目实现手部关节实时跟踪、识别不同手势,并将结果应用于Unity交互式应用开发。