访问:

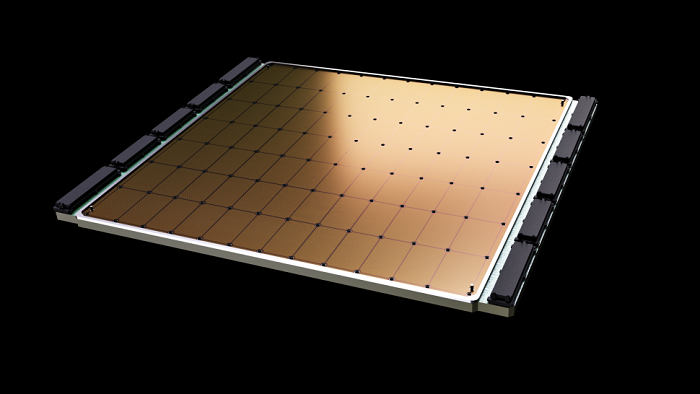

Wafer Scale Engine-2 晶圆级芯片资料图(来自:Cerebras)

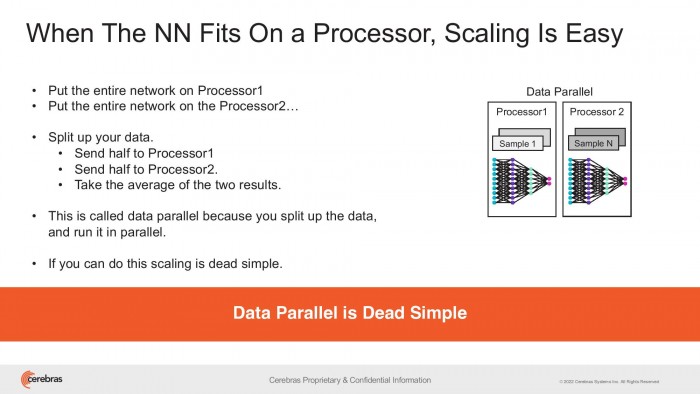

本次演示使用了 OpenAI 的 120 亿参数 DALL-E,且所有工作负载无需扩展到横跨多个加速器的平台上去完成,从而极大地降低了对基础设施和软件的复杂性要求。

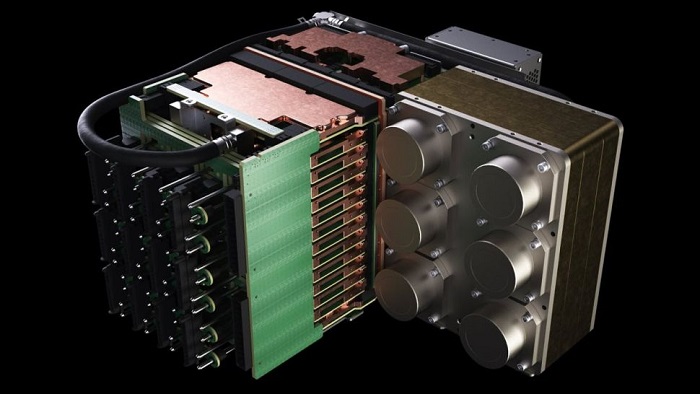

不过需要指出的是,单个 CS-2 系统本身就已经可以媲美超算 —— 7nm 单晶圆(通常可容纳数百枚主流芯片),拥有惊人的 2.6 万亿个晶体管、85 万个内核、40GB 集成缓存,且封装功耗高达 15kW 。

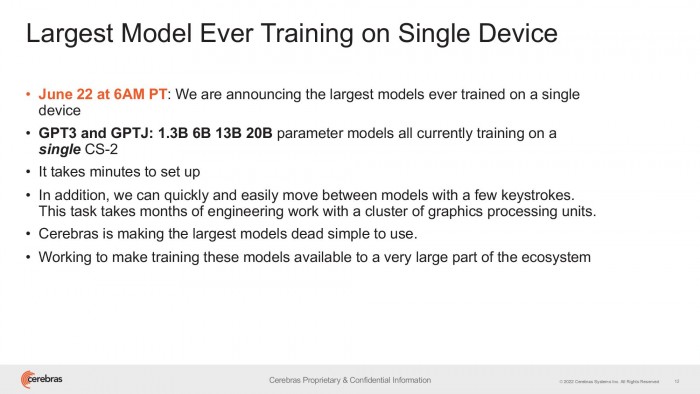

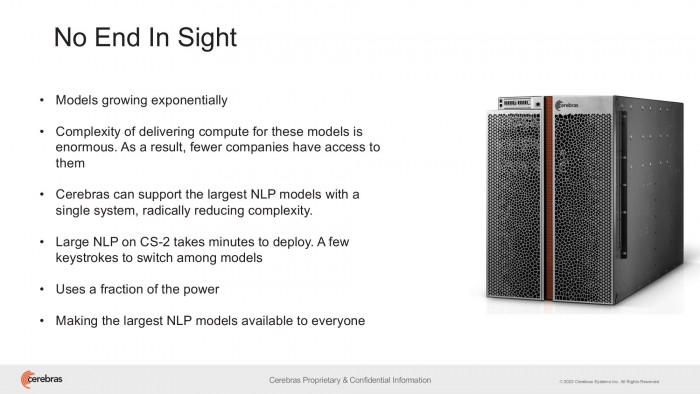

Cerebras 尝试在单个芯片上保留多达 200 亿个参数的 NLP 模型,以显著降低数以千计的 GPU 训练成本、扩展所需的相关硬件需求,并且消除了在它们之间划分模型的技术难度。

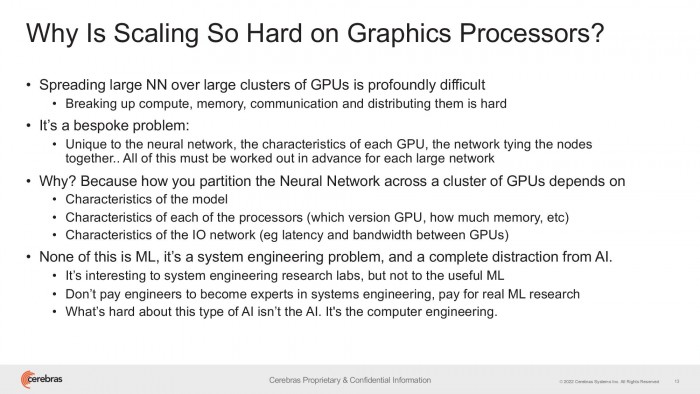

Cerebras 指出,这也是常规 NLP 工作负载的痛点之一,有时动辄需要耗费数月时间才能完成。

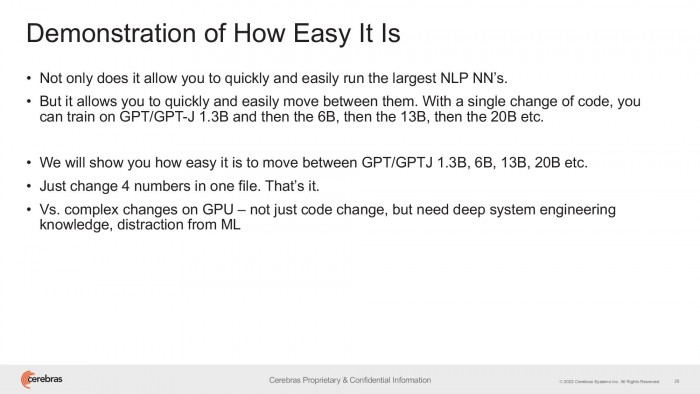

由于高度定制,每个正在处理的神经网络、GPU 规格、以及将它们联系到一起的网络,都是独一无二的 —— 这些元素必须在初次训练前就搞定,且无法做到跨系统移植。

至于 OpenAI 的 GPT-3 自然预览处理模型,它有时已经能够编写出让你误以为是真人所撰写的整篇文章,且具有 1750 亿个惊人的参数。

不过 DeepMind 在 2021 年底推出的 Gopher,已将这个数字大幅提升到了 2800 亿,且 Google Brain 甚至宣布训练了一个超万亿参数的 Switch Transformer 模型。

Cerebras 首席执行官兼联合创始人 Andrew Feldman 表示:更大的 NLP 模型,意味着它的准确度也更高。

但通常只有极少数公司拥有如此庞大的必要资源和专业知识,来分解这些大型模型、并将之分散到数百、或数千个 GPU 上去艰苦运算。

正因如此,我们只看到过极少数公司能够训练大型 NLP 模型 —— 这对行业内的其他人来说过于昂贵、耗时、且难以使用。

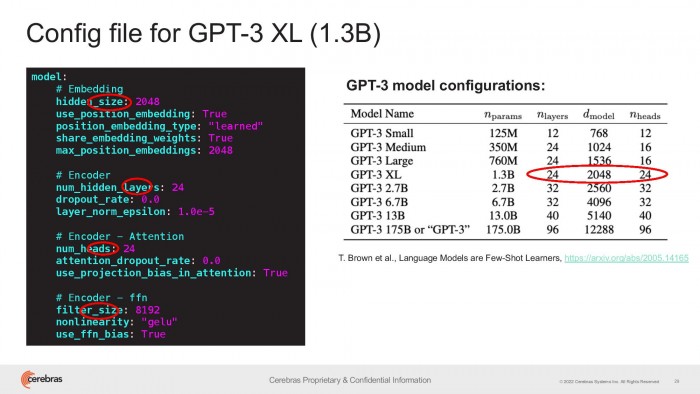

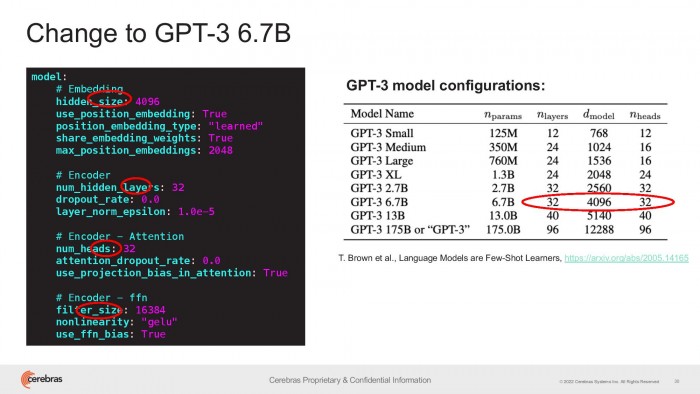

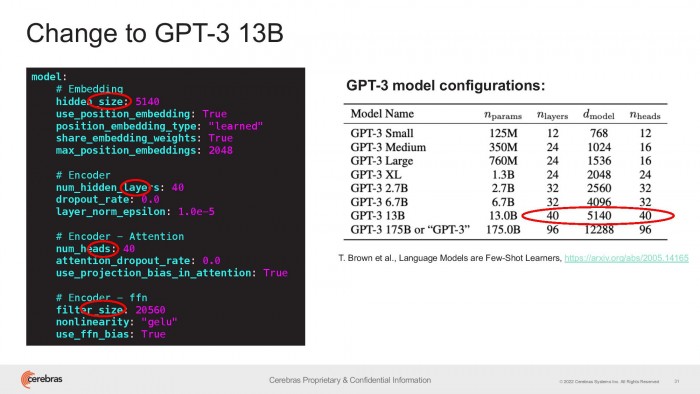

今天,Cerebras 很自豪地宣布普及了 GPT-3XL 1.3B、GPT-J 6B、GPT-3 13B 和 GPT-NeoX 20B,让整个 AI 生态系统都能够在几分钟内建立大型模型、并在单个 CS-2 平台上展开训练。

不过与 CPU 领域类似,主频只是衡量性能的其中一项指标。比如 Chinchilla 就尝试通过使用更少的参数(700 亿个),得出了较 GPT-3 和 Gopher 更好的结果。